El precio a pagar por tener IA es el saqueo de todo el contenido de Internet. Y Perplexity es solo el último ejemplo

Midjourney y ChatGPT parecen mágicos. Crean obras digitales y textos de una forma asombrosa, y aunque a menudo meten la pata, sus resultados son a menudo convincentes e incluso impresionantes. Esa foto parece del Papa con abrigo de Balenciaga sigue pareciendo real, y ese código en Python funciona. Insisto. Parecen mágicos.

Pero tanto estos modelos de IA generativa como sus competidores no son mágicos. Son loros estocásticos que hacen uso de patrones estadísticos. No entienden lo que crean o generan. Y además, todo lo que hacen está basado en algo aún más importante.

Robar.

Si está en internet, puedo usarlo para mi IA

Es lo que están haciendo desde el principio. Las grandes empresas de IA necesitan ingentes cantidades de datos para entrenar a sus modelos, así que lo que han hecho es, sencillamente, cogerlos de internet. Sin avisar, sin pedir permiso, y sin aclarar luego qué datos habían usado.

Ninguna empresa de IA aclara cómo ha entrenado a esos modelos. No sabemos con exactitud de dónde han sacado toda la información. ¿Qué libros, sitios web, o imágenes han incluido en el entrenamiento? La transparencia es prácticamente nula.

Ninguna lo aclara del todo, y todas las empresas se escudan en el concepto del “uso justo” (fair use). Este concepto desarrollado en el derecho anglosajón permite el uso limitado de material protegido sin que sea necesario pedir permiso por hacerlo.

Esa recolección masiva y voraz de datos ha hecho que muchas empresas de IA comiencen a tener problemas legales. Las demandas por posibles violaciones de propiedad intelectual comenzaron a llegar muy pronto y se fueron haciendo cada vez más frecuentes.

¿Qué comenzaron a hacer las empresas de IA ante esas demandas (o la amenaza de que acabaran afectándolas)? Llegar a acuerdos con algunos proveedores de contenidos.

Antes algunas cogían todo lo que podían de plataformas como Reddit, pero ahora tanto Google como OpenAI han resuelto sus diferencias tras negociar distintos tipos de quid pro quo.

Y lo que ha pasado con Reddit ha pasado con grupos editoriales como Prisa o Le Monde, y seguirá ocurriendo en el futuro: así las grandes de la IA se protegen y pueden seguir alimentando sus modelos sin parar.

Perplexity y las gotas que colman los vasos

Pero hay comportamientos aún más conflictivos. Tenemos un ejemplo perfecto en Perplexity, que poco a poco se convirtió en una sorprendente alternativa a Google e incluso a la Wikipedia.

Aquí nos hemos encontrado no con un motor de búsquedas, sino, como apuntaban en The Verge, con un “motor de respuestas”. El problema es cómo ha logrado hacer lo que hace.

Que no es ni más ni menos que robando.

Lo ha hecho aún en mayor medida que algunas de sus competidoras, porque esta startup está haciendo cosas inauditas. En primer lugar, está plagiando artículos enteros de otros medios. Lo hizo con un tema de Wired, por ejemplo.

En segundo, está saltándose los muros de pago de publicaciones como Forbes para poder recolectar información relativa a ciertos temas. No solo se saltó ese muro de pago, sino que apenas citó la investigación original de Forbes y plagió los gráficos e imágenes de ese tema.

El descubrimiento generó una nueva polémica en este ámbito. En Wired directamente acusaron a Perplexity de ser una máquina de hacer mierda, pero la empresa intentó salir al paso indicando que está debatiendo la forma de compartir ingresos con las publicaciones.

Esa empresa de inteligencia artificial no es la única en saltarse esos muros: estos días se ha revelado que Poe, el chatbot de la plataforma de preguntas y respuestas Quora, también lo hacía. Mientras que algunos expertos afirman que esto es una violación clara de los derechos de autor de esos contenidos, en Quora afirman que no es así y que se basan en servicios del tipo “leer más tarde” que cumplen con la ley.

Y entonces llegó el tercer y último descubrimiento a manos de un desarrollador llamado Robb Knight. Como explicó en su blog, en Perplexity estaban ignorando las directrices de los ficheros robots.txt que precisamente indican a los rastreadores de internet qué páginas rastrear y cuáles no.

Esos pequeños ficheros siempre han servido como forma de hacer que por ejemplo Google no mostrase en sus resultados ciertas partes de un sitio wbe, pero a los chicos de Perplexity les daba igual: ellos lo recolectaban absolutamente todo.

Srinivas echó balones fuera: no eran ellos quienes se los saltaban, sino las empresas que habían contratado para que rastrearan la web y suministraran más y más datos para su modelo de IA. Y cómo no, Perplexity no es la única en esquivar e ignorar los ficheros robots.txt: OpenAI y Anthropic hacen exactamente lo mismo.

Esa actitud ha hecho que por ejemplo Reddit se ponga en pie de guerra contra los scrapers, aunque la cosa ya venía de lejos. The New York Times, por ejemplo, demandó a Microsoft y a OpenAI porque no quiere que un chatbot mate al periodismo. Este diario ya publicó un reportaje en abril de 2024 avisando de cómo la voracidad de empresas como OpenAI, Google o Meta estaban (supuestamente) pasándose de la raya a la hora de entrenar sus modelos.

Pero es que ahí no acaba todo.

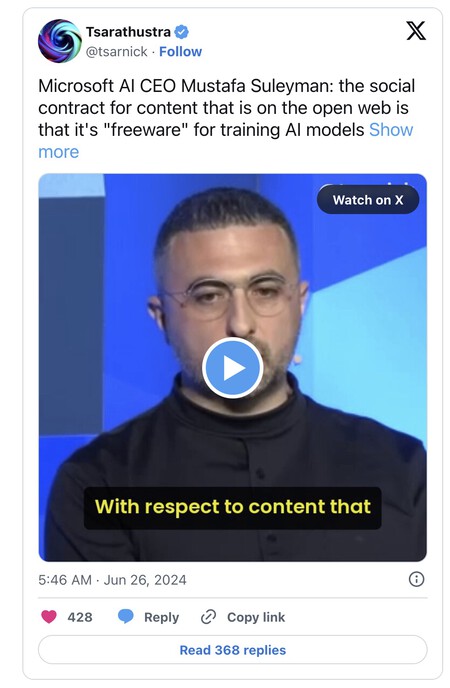

Así lo demostraba el responsable de IA de Microsoft, Mustafa Suleyman, que en una entrevista reciente con CNBC defendía esa recolección indiscriminada de datos en internet:

“Creo que con respecto al contenido que ya está en la web abierta, el contrato social de ese contenido desde los años 90 ha sido que es de uso justo. Cualquiera puede copiarlo, recrearlo, reproducirlo. Ese ha sido el “freeware”, si se quiere, ese ha sido el entendimiento”.

Esa afirmación es terrible, sobre todo porque asume justo lo que están asumiendo todas las grandes de internet. Que no es más ni menos que todo lo que publicamos en internet está ahí para que ellas hagan lo que quieran con ello.

Que es precisamente lo que están haciendo.

Imagen | Xataka con Freepik